240707_昇思学习打卡-Day19-基于MindSpore通过GPT实现情感分类

今天基于GPT实现一个情感分类的功能,假设已经安装好了MindSpore环境。

# 该案例在 mindnlp 0.3.1 版本完成适配,如果发现案例跑不通,可以指定mindnlp版本,执行`!pip install mindnlp==0.3.1`

!pip install mindnlp

!pip install jieba

%env HF_ENDPOINT=https://hf-mirror.com

导包导包

import os

import mindspore

from mindspore.dataset import text, GeneratorDataset, transforms

from mindspore import nn

from mindnlp.dataset import load_dataset

from mindnlp._legacy.engine import Trainer, Evaluator

from mindnlp._legacy.engine.callbacks import CheckpointCallback, BestModelCallback

from mindnlp._legacy.metrics import Accuracy

# 加载IMDb数据集

imdb_ds = load_dataset('imdb', split=['train', 'test'])

# 获取训练集

imdb_train = imdb_ds['train']

# 获取测试集

imdb_test = imdb_ds['test']

# 调用get_dataset_size方法来获取训练集的大小

imdb_train.get_dataset_size()

import numpy as np

def process_dataset(dataset, tokenizer, max_seq_len=512, batch_size=4, shuffle=False):

"""

处理数据集,使用tokenizer对文本进行编码,并根据指定的batch大小和序列长度组织数据。

参数:

- dataset: 需要处理的数据集,包含文本和标签。

- tokenizer: 用于将文本转换为token序列的tokenizer。

- max_seq_len: 最大序列长度,超过该长度的序列将被截断。

- batch_size: 打包数据的批次大小。

- shuffle: 是否在处理数据集前对其进行洗牌。

返回:

- 经过tokenization和batch处理后的数据集。

"""

# 判断是否在Ascend设备上运行

is_ascend = mindspore.get_context('device_target') == 'Ascend'

def tokenize(text):

"""

对文本进行tokenization,并返回input_ids和attention_mask。

参数:

- text: 需要被tokenize的文本。

返回:

- tokenize后的input_ids和attention_mask。

"""

# 根据设备类型选择合适的tokenization方法

if is_ascend:

tokenized = tokenizer(text, padding='max_length', truncation=True, max_length=max_seq_len)

else:

tokenized = tokenizer(text, truncation=True, max_length=max_seq_len)

return tokenized['input_ids'], tokenized['attention_mask']

# 如果需要洗牌,对数据集进行洗牌操作

if shuffle:

dataset = dataset.shuffle(batch_size)

# 对数据集进行tokenization操作

# map dataset

dataset = dataset.map(operations=[tokenize], input_columns="text", output_columns=['input_ids', 'attention_mask'])

# 将标签转换为int32类型

dataset = dataset.map(operations=transforms.TypeCast(mindspore.int32), input_columns="label", output_columns="labels")

# 根据设备类型选择合适的批次处理方法

# batch dataset

if is_ascend:

dataset = dataset.batch(batch_size)

else:

dataset = dataset.padded_batch(batch_size, pad_info={'input_ids': (None, tokenizer.pad_token_id),

'attention_mask': (None, 0)})

return dataset

import numpy as np

def process_dataset(dataset, tokenizer, max_seq_len=512, batch_size=4, shuffle=False):

"""

处理数据集,使用tokenizer对文本进行编码,并根据指定的batch大小和序列长度组织数据。

参数:

- dataset: 需要处理的数据集,包含文本和标签。

- tokenizer: 用于将文本转换为token序列的tokenizer。

- max_seq_len: 最大序列长度,超过该长度的序列将被截断。

- batch_size: 打包数据的批次大小。

- shuffle: 是否在处理数据集前对其进行洗牌。

返回:

- 经过tokenization和batch处理后的数据集。

"""

# 判断是否在Ascend设备上运行

is_ascend = mindspore.get_context('device_target') == 'Ascend'

def tokenize(text):

"""

对文本进行tokenization,并返回input_ids和attention_mask。

参数:

- text: 需要被tokenize的文本。

返回:

- tokenize后的input_ids和attention_mask。

"""

# 根据设备类型选择合适的tokenization方法

if is_ascend:

tokenized = tokenizer(text, padding='max_length', truncation=True, max_length=max_seq_len)

else:

tokenized = tokenizer(text, truncation=True, max_length=max_seq_len)

return tokenized['input_ids'], tokenized['attention_mask']

# 如果需要洗牌,对数据集进行洗牌操作

if shuffle:

dataset = dataset.shuffle(batch_size)

# 对数据集进行tokenization操作

# map dataset

dataset = dataset.map(operations=[tokenize], input_columns="text", output_columns=['input_ids', 'attention_mask'])

# 将标签转换为int32类型

dataset = dataset.map(operations=transforms.TypeCast(mindspore.int32), input_columns="label", output_columns="labels")

# 根据设备类型选择合适的批次处理方法

# batch dataset

if is_ascend:

dataset = dataset.batch(batch_size)

else:

dataset = dataset.padded_batch(batch_size, pad_info={'input_ids': (None, tokenizer.pad_token_id),

'attention_mask': (None, 0)})

return dataset

# 导入来自mindnlp库transformers模块中的GPTTokenizer类

from mindnlp.transformers import GPTTokenizer

# 初始化GPT分词器,使用预训练的'openai-gpt'模型

# 分词器

gpt_tokenizer = GPTTokenizer.from_pretrained('openai-gpt')

# 定义一个特殊token字典,包括开始、结束和填充token

special_tokens_dict = {

"bos_token": "<bos>", # 开始符号

"eos_token": "<eos>", # 结束符号

"pad_token": "<pad>", # 填充符号

}

# 向分词器中添加特殊token,并返回添加的token数量

num_added_toks = gpt_tokenizer.add_special_tokens(special_tokens_dict)

# 将训练数据集imdb_train分割成训练集和验证集

# 按照70%训练集和30%验证集的比例进行划分

imdb_train, imdb_val = imdb_train.split([0.7, 0.3])

dataset_train = process_dataset(imdb_train, gpt_tokenizer, shuffle=True)

dataset_val = process_dataset(imdb_val, gpt_tokenizer)

dataset_test = process_dataset(imdb_test, gpt_tokenizer)

# 调用create_tuple_iterator方法创建一个迭代器,并通过next函数获取迭代器的第一个元素

# 这里的目的是为了展示或测试迭代器是否能正常生成数据

# 对于参数和返回值的详细说明,需要查看create_tuple_iterator方法的文档或实现

next(dataset_train.create_tuple_iterator())

# 导入GPT序列分类模型与Adam优化器

from mindnlp.transformers import GPTForSequenceClassification

from mindspore.experimental.optim import Adam

# 初始化GPT模型用于序列分类任务,设置标签数量为2(二分类任务)

# 设置模型配置并定义训练参数

model = GPTForSequenceClassification.from_pretrained('openai-gpt', num_labels=2)

# 配置模型的填充标记ID以匹配分词器设置

model.config.pad_token_id = gpt_tokenizer.pad_token_id

# 调整令牌嵌入层大小以适应新增词汇量

model.resize_token_embeddings(model.config.vocab_size + 3)

# 使用2e-5的学习率初始化Adam优化器

optimizer = nn.Adam(model.trainable_params(), learning_rate=2e-5)

# 初始化准确度指标来评估模型性能

metric = Accuracy()

# 定义回调函数以在训练过程中保存检查点

# 定义保存检查点的回调函数

ckpoint_cb = CheckpointCallback(save_path='checkpoint', ckpt_name='gpt_imdb_finetune', epochs=1, keep_checkpoint_max=2)

# 初始化最佳模型回调函数以保存表现最优的模型

best_model_cb = BestModelCallback(save_path='checkpoint', ckpt_name='gpt_imdb_finetune_best', auto_load=True)

# 初始化训练器,包括模型、训练数据集、评估数据集、性能指标、优化器以及回调函数

trainer = Trainer(network=model, train_dataset=dataset_train,

eval_dataset=dataset_train, metrics=metric,

epochs=1, optimizer=optimizer, callbacks=[ckpoint_cb, best_model_cb],

jit=False)

# 导入GPT序列分类模型与Adam优化器

from mindnlp.transformers import GPTForSequenceClassification

from mindspore.experimental.optim import Adam

# 初始化GPT模型用于序列分类任务,设置标签数量为2(二分类任务)

# 设置模型配置并定义训练参数

model = GPTForSequenceClassification.from_pretrained('openai-gpt', num_labels=2)

# 配置模型的填充标记ID以匹配分词器设置

model.config.pad_token_id = gpt_tokenizer.pad_token_id

# 调整令牌嵌入层大小以适应新增词汇量

model.resize_token_embeddings(model.config.vocab_size + 3)

# 使用2e-5的学习率初始化Adam优化器

optimizer = nn.Adam(model.trainable_params(), learning_rate=2e-5)

# 初始化准确度指标来评估模型性能

metric = Accuracy()

# 定义回调函数以在训练过程中保存检查点

# 定义保存检查点的回调函数

ckpoint_cb = CheckpointCallback(save_path='checkpoint', ckpt_name='gpt_imdb_finetune', epochs=1, keep_checkpoint_max=2)

# 初始化最佳模型回调函数以保存表现最优的模型

best_model_cb = BestModelCallback(save_path='checkpoint', ckpt_name='gpt_imdb_finetune_best', auto_load=True)

# 初始化训练器,包括模型、训练数据集、评估数据集、性能指标、优化器以及回调函数

trainer = Trainer(network=model, train_dataset=dataset_train,

eval_dataset=dataset_train, metrics=metric,

epochs=1, optimizer=optimizer, callbacks=[ckpoint_cb, best_model_cb],

jit=False)

# 执行模型训练

trainer.run(tgt_columns="labels")

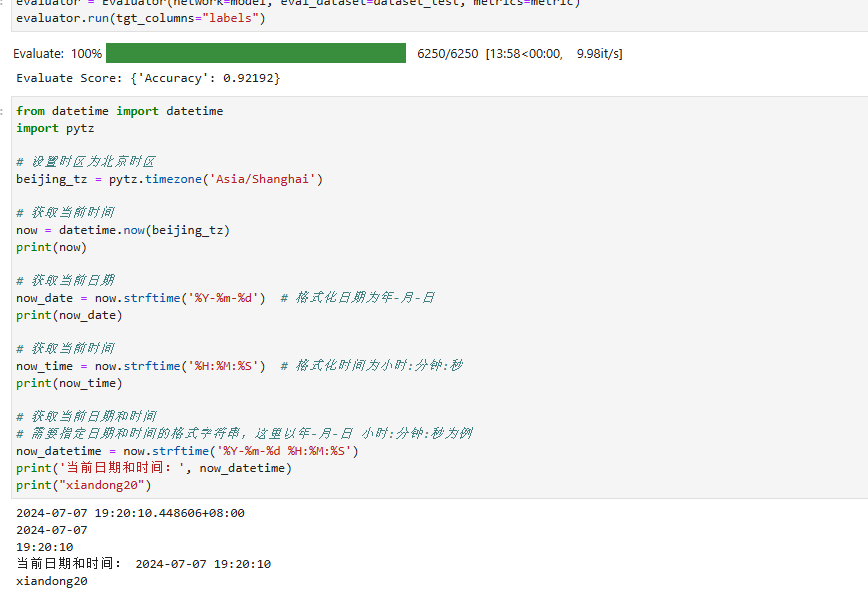

# 初始化Evaluator对象,用于评估模型性能

# 参数说明:

# network: 待评估的模型

# eval_dataset: 用于评估的测试数据集

# metrics: 评估指标

evaluator = Evaluator(network=model, eval_dataset=dataset_test, metrics=metric)

# 执行模型评估,指定目标列作为评估标签

# 该步骤将计算模型在测试数据集上的指定评估指标

evaluator.run(tgt_columns="labels")

打卡图片: